Umgang mit Ergebnissen der Lehrevaluation

16.05.2023

Lehrevaluationsergebnisse sinnvoll nutzen: Daten interpretieren, Feedback einordnen und Lehre mit Studierenden verbessern.

Tiefgreifende Veränderungen des deutschen Hochschulsystems der beiden letzten Jahrzehnte – u. a. der Bologna-Prozess – rückten Aspekte, wie Evaluation von Lehre und im weiteren Sinne Qualitätsmanagement von Studium und Lehre, in den Aufmerksamkeitsfokus von Hochschulen. Seit 1998 ist für Deutschland im Hochschulrahmengesetz (HRG § 6) die Verpflichtung der Hochschulen zur regemäßigen Bewertung der Lehre, unter Beteiligung der Studierenden, festgeschrieben. In diesem Zusammenhang etablierte sich das Instrument der Lehrveranstaltungsevaluation/Lehrevaluation im deutschen Hochschulraum als effiziente Methode zur systematischen Bewertung von Lehre aus Studierendenperspektive. Gemeinhin werden zwei wesentliche Zielsetzungen der Lehrevaluation angeführt:

- Lehrenden ein unmittelbares Feedback zu ihrer Lehrtätigkeit sowie zu beeinflussenden Rahmenbedingungen zu bieten – mit der Chance zur direkten Optimierung (im Sinne eines unterstützenden, formativen Evaluationsansatzes)

- Lehrende und Studierende in einen Dialog über (gute) Lehre zu bringen und damit Lehre weiterzuentwickeln

Die an den Hochschulen zumeist zentral koordinierte und standardisierte Lehrevaluation stellt für Lehrende ein hilfreiches und zweckmäßiges Instrument dar, indem sie ohne großen Ressourcen- und Zeiteinsatz, über die Zeit vergleichbare Rückmeldung bietet und das Einschätzen, Reflektieren und Optimieren der Lehre möglich macht. Hierfür werden Studierende, mit ihrer Erfahrung aus vielen unterschiedlichen Lehrveranstaltungen sowie ihrem Interesse an guter Lehre – begründet durch ihr Ziel der Berufsqualifizierung – einbezogen.

Wie sind Lehrevaluationen gestaltet und wie kann ich die Ergebnisse interpretieren?

Gestaltung

Instrumente zur Lehrevaluation (hier: Fragebögen) an deutschen Hochschulen orientieren sich im Ursprung an solchen, die initial aus dem angloamerikanischen System der Lehrevaluation stammen. Bei der konkreten Konzipierung und Umsetzung von Fragebögen stützten und stützen sich entsprechende Hochschuleinheiten größtenteils auf die für Deutschland wegweisenden empirischen Arbeiten von Heiner Rindermann (Professor für Pädagogische und Entwicklungspsychologie, TU Chemnitz).

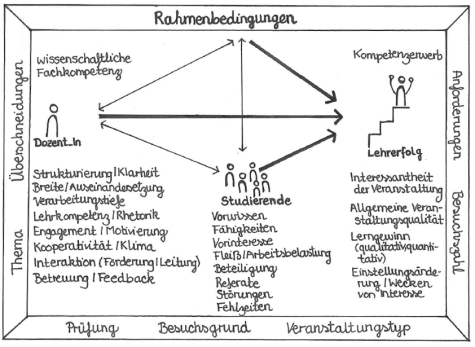

Mittels umfangreicher Analysen von Studierenden- und Lehrendenbefragungen konstruierte er das sogenannte „Heidelberger Inventar zur Lehrveranstaltungsevaluation“ (HILVE-I, revidierte Form: HILVE-II) mit Dimensionen von Lehre und Lehrqualität sowie passenden Fragebogen-Items (Rindermann & Amelang, 1994b; Rindermann, 2009). Als Weiterentwicklung des Inventars entwarf Rindermann das sogenannte „Multifaktorielle Modell der Lehrveranstaltungsqualität“ (Rindermann & Amelang, 1994a). Dieses Modell versteht Qualität von Lehre bzw. „Lehrerfolg“ als Ergebnis des Zusammenspiels mehrerer, sich gegenseitig beeinflussender Faktoren (siehe Abbildung 1) und liegt dem an der TU Darmstadt verwendeten Fragebogen zur Lehrveranstaltungsevaluation zugrunde. Erst das Zusammenspiel aus dem Handeln des Dozenten bzw. der Dozentin, dem Handeln der Studierenden und günstigen Rahmenbedingungen bewirkt „Lehrerfolg“ mit großer Wahrscheinlichkeit (Rindermann, 2009, S. 63 f.).

Der Fragebogen der TU Darmstadt bildet die Faktoren aus Abbildung 1 über folgende Themenblöcke ab:

- Vermittlung der Inhalte/Darbietung des Lehrstoffs (Modell-Faktor: Handeln der Dozent_in)

- Engagement der Lehrenden (Modell-Faktor: Handeln der Dozent_in)

- Anforderungen und Arbeitsaufwand (Modell-Faktor: Handeln der Studierenden und Rahmenbedingungen)

- Lernerfolg und studentische Zufriedenheit (Modell-Faktor: Lehrerfolg)

Entsprechend des State of the Art der Fragebogenkonzeption, wird die Operationalisierung dieser Themenblöcke mittels sogenannter geschlossener (quantitativer) und offener (qualitativer) Fragen, mit Spielraum für veranstaltungsspezifische Fragen, vorgenommen. Die geschlossenen Fragen werden standardmäßig durch offene Fragen bzw. Kommentarfelder ergänzt, um der gewissen Determiniertheit von Fragebögen (Vorgabe von Fragen, Antwortskalen und -kategorien) Rechnung zu tragen.

Interpretation und Umgang

Von Studierenden ausgefüllte Lehrevaluationsfragebögen werden an der TU Darmstadt durch den Arbeitsbereich Evaluation maschinell ausgewertet. Die Auswertungen werden den Lehrenden anschließend in Form von Standardergebnisberichten zugesandt.

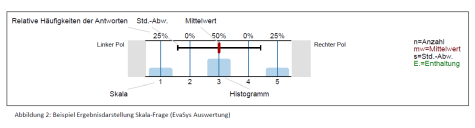

Für alle geschlossenen (Skala )Fragen werden im Ergebnisbericht Kennzahlen, wie Anzahl der Antworten, Mittelwerte, relative Häufigkeiten und Standardabweichung/Streuung der Antworten, dargestellt (siehe Abbildung 2). Frei formulierte Kommentare zu offenen Fragen sind ebenfalls im Standardergebnisbericht ausgewiesen, müssen von Lehrenden jedoch selbst ausgewertet, z. B. kategorisiert und quantifiziert, werden.

Siehe Abbildung 2 Beispiel Ergebnisdarstellung.

Geschlossene (quantitative) Fragen

|

In der Regel machen sogenannte Skala-Fragen (neben Single-Choice- und Multiple-Choice-Fragen) den größten Teil der geschossenen Fragen in Lehrevaluations-Fragebögen aus. Sie zeichnen sich durch Antwortskalen mit entsprechenden Polen aus; an der TU Darmstadt durch eine fünfstufige Antwortskala mit den Polen 1: „trifft zu“ und 5: „trifft nicht zu“. Nachstehende Tabelle fasst die grundlegenden Interpretationsweisen der für Skala-Fragen dargestellten Kennzahlen zusammen: |

Relative Häufigkeiten:

|

Mittelwert (mw):

|

Standardabweichung/Streuung (s):

|

|

Einen ersten Eindruck der studentischen Bewertung der einzelnen Fragen, bietet der Mittelwert. Erfahrungsgemäß beurteilen Studierende der TU Darmstadt das Engagement der Lehrenden und die Lehrkompetenz sehr positiv; Mittelwerte bewegen sich in der Regel im Bereich zwischen 1 und 2,5 bei der oben beschriebenen fünfstufigen Skala (1: positiver Pol). Bei der Interpretation der einzelnen Mittelwerte ist durchaus ein individueller Spielraum gegeben. Daher wird empfohlen darüber nachzudenken, welches der individuelle Idealwert ist und diesen bei der Interpretation der Ergebnisse anzulegen. Falls der Idealwert deutlich vom realen Mittelwert divergiert oder die studentischen Antworten stark um den Mittelwert streuen (erfahrungsgemäß stellt s > 1,0 eine große Streuung dar), können die studentischen Kommentare der offenen Fragen und/oder ein Gespräch mit den Studierenden zu unerwarteten Einzelergebnissen, aufschlussreich sein (siehe unten: „Mit Studierenden über Lehrevaluationsergebnisse sprechen“). Generell sollten Evaluationsergebnisse detaillierter betrachtet werden und neben den Mittelwerten immer auch die Standardabweichungen in die Betrachtung einschließen. Denn wie in obiger Tabelle notiert, bietet die Standardabweichung Information darüber, wie einig sich Studierende bei der Beurteilung einer Frage bzw. eines Aspektes von Lehre sind. So können Studierendengruppen beispielsweise sehr heterogen (Vorwissen, Erfahrung, Interesse am Thema…) zusammengesetzt sein. Liegt hier beispielsweise eine breite, uneindeutige Antwortverteilung vor, bietet dies wieder Anlass mit Studierenden über mögliche Gründe ins Gespräch zu kommen. Andererseits könnte zum Vorschein kommen, dass nur einzelne Studierende Extremwerte (z. B. im negativen Falle den Wert 5) vergaben und sich entsprechend negative/positive Mittelwerte relativieren lassen. Durch einzelne Extremwerte bzw. Einzelmeinungen verzerrte Mittelwerte sollten nicht überinterpretiert werden. |

Einordnung der Lehrevaluationsergebnisse – Vergleichswerte

Erfahrungsgemäß wünschen sich Lehrende eine Möglichkeit zur persönlichen Einordnung, mindestens ihrer quantitativen Lehrevaluationsergebnisse, z. B. in Form von Vergleichswerten anderer Lehrevaluationen. Die TU Darmstadt bietet Lehrenden, ähnlich wie die meisten Hochschulen, sogenannte Profillinienvergleiche. Dabei werden im Ergebnisbericht zusätzlich Mittelwerte der geschlossenen Fragen anderer Lehrevaluationen oder der eigenen Lehrevaluationen über die Zeit dargestellt.

Zwar werden für Vergleichswerte aus anderen Lehrevaluationen in der Regel sinnvolle Einheiten aggregiert, wie Lehrevaluationen eines Faches/einer Fakultät und Veranstaltungen mit ähnlichen Teilnahmezahlen oder mit gleichem Format (z. B. Vorlesung, Seminar, Praktikum). Damit bieten diese eine approximative Orientierung sowie Reduzierung des oben genannten individuellen Interpretationsspielraums. Demgegenüber gilt es bei dieser Orientierungsmöglichkeit zu bedenken, dass Lehre und Lehrveranstaltungen entsprechend Rindermann (2009, S. 26) nicht einheitliche, handliche, ubiquitäre Programme darstellen und somit der Vergleich von Lehrenden eines Faches in Form ihrer Lehrevaluationsergebnisse fragwürdig sei bzw. zumindest mit Bedacht interpretiert werden sollte.

Offene (qualitative) Fragen

Ergebnisse von Lehrevaluationsforschung (Alhija & Fresko, 2009) und Rückmeldungen von Lehrenden zu Lehrevaluationsergebnissen zeigen, dass gerade Ergebnisse offener Fragen – also freie studentische Kommentare – von Lehrenden sehr geschätzt oder sogar als der wertvollste Ergebnisteil angesehen werden. Der Stellenwert der Kommentare ist nachvollziehbar, bieten sie doch Originaltöne zur eigenen Lehre bzw. wertvolle Informationen über die „Kreuzchen“ der geschlossenen Fragen hinaus. Studien zeigen relativ große Varianz im Anteil der Studierenden (zwischen 10 und 70 %), die bei Lehrevaluationen Kommentare verfassen (Alhija & Fresko, 2009; Brockx et al., 2012; Theall & Franklin, 1991) und einen Zusammenhang zwischen der Globalbewertung einer Lehrveranstaltung und der Anzahl an verfassten Kommentaren. Alhija und Fresko (2009) zeigen, dass Studierende die meisten Kommentare für die am besten als auch für die am schlechtesten beurteilten Veranstaltungen hinterlassen. Inhaltlich betrachtet zeigt sich, dass mehrheitlich wertschätzendes und konstruktives Feedback gegeben wird. So machen Studierende eher positive und konkrete didaktische oder organisatorische Verbesserungsvorschläge statt global negative Aussagen (Alhija & Fresko, 2009; Brockx et al., 2012). In selteneren Fällen kommt es unter dem Deckmantel der Anonymität auch zu unsachlichen oder grenzüberschreitenden studentischen Kommentaren.

Neben der rein inhaltlichen Betrachtung studentischer Kommentare, besteht ein weiteres bedeutendes Potential der schriftlichen Kommentare darin, dass häufig Bezüge zu den in geschlossenen Fragen erhobenen Lehraspekten hergestellt werden (können) (Alhija & Fresko, 2009; Brockx et al., 2012). Zum einen konkretisieren Studierende, wie Lehraspekte optimiert werden könnten. So lautet ein beispielhafter Kommentar: „Eine zusammenfassende Folie am Anfang der Veranstaltung hätte mir für den Überblick geholfen“ und nimmt somit Bezug auf die mögliche geschlossene Frage/das geschlossene Item: „Die Veranstaltung ist inhaltlich gut strukturiert (roter Faden)“. Zum anderen lassen sich studentische Kommentare durch Lehrende in ihrer Repräsentativität einschätzen, indem sie gemeinsam mit – und nicht isoliert von – den Ergebnissen, also Antwortverteilungen der geschlossenen Fragen interpretiert werden. Warum dieser Bezug essenziell ist, legt die empirische Studie von Nowakowski und Hannover (2015) nahe. Sie zeigt, dass Lehrende bei der Interpretation qualitativer Lehrevaluationsergebnisse Heuristiken nutzen, also einfache kognitive „Patentlösungen“, mit deren Hilfe schnell und effizient Schlüsse gezogen werden können (vgl. Gerrig & Zimbardo, 2004, S. 374). Konkret findet die sogenannte Repräsentativitätsheuristik übermäßige Anwendung. Dabei ziehen Menschen mögliche Fehlschlüsse, indem sie eine singuläre Information als repräsentativ für eine Vielzahl an Information ansehen und auf dieser Grundlage über die Gesamtinformation urteilen. Auf Lehrevaluationsergebnisse übertragen bedeutet dies, dass Lehrende dazu tendieren, einzelne – insbesondere negative – Studierendenkommentare als prototypisch für ihre Gesamtergebnisse anzusehen und sich von diesen besonders beeinflussen lassen (Nowakowski & Hannover, 2015). Um Fehlschlüsse dieser Art zu vermeiden, wird folgendes Vorgehen empfohlen:

- Quantifizierung von Kommentaren mit gleichem Inhalt. Wird ein und derselbe Aspekt mehr als einmal von den Studierenden genannt? Einzelkommentare bzw. -meinungen können bei der weiteren Interpretation ausgeschlossen werden. Mehrfach genannte Aspekte sollten generell gewichtiger behandelt werden.

- (Quantifizierte) Kommentare mit Antwortverteilungen passender geschlossener Fragen in Bezug setzten. Kann von einzelnen studentischen Kommentaren auf die Mehrheitsmeinung geschlossen werden? Divergiert die Antwortverteilung der gesamten Studierendengruppe deutlich von den einzelnen Kommentarinhalten, sollten die Kommentare weniger gewichtig behandelt werden.

Wie oben erwähnt, verfassen Studierende in Einzelfällen unfaire, verletzende oder grenzüberschreitende Kommentare. Wie kann mit Kommentaren solcherart umgegangen werden? Zunächst empfiehlt es sich diese sachlich und nicht persönlich zu nehmen und dem oben genannten Vorgehen (1. und 2.) zu folgen. Vermutlich stellen entsprechende Kommentare Einzelmeinungen dar und können aus der weiteren Ergebnisinterpretation ausgeschlossen werden. Soll unfairen Kommentaren dennoch weiter auf den Grund gegangen werden, hilft bei der Umdeutung ins Sachliche und dem weiteren Umgang mit diesen, die Orientierung an Leitfragen:

- Ist der Kommentar personenbezogen und/oder für die Lehre (ir-)relevant?

Übergeordnete Zielsetzung der Lehrevaluation ist die Weiterentwicklung und Optimierung von Lehre. Dies sollte im Blick behalten werden, wenn Kommentare wie der nachstehende gelesen werden: „Der neue Haarschnitt ist echt schlimm!“

Diese studentische Aussage ist ausschließlich auf einen Aspekt der Lehrperson bezogen, welcher für die Lehre irrelevant ist. Entsprechende Kommentare begründen sich möglicherweise auf negativen Erfahrungen der Studierenden im Studium. Fälschlicherweise wird die Lehrevaluation manchmal als Ventil für studentischen Frust genutzt. In solchen Fällen sollten Kommentare als irrelevant eingeordnet und aus der weiteren Betrachtung der Lehrevaluationsergebnisse ausgeklammert werden. - Ist der im Kommentar genannte Aspekt veränderbar?

Beispielkommentar: „Wir wollen einen Mann.“

Zum Teil passiert es, dass Studierende Kommentare oder Vorschläge verfassen, bei welchen Lehrende machtlos sind, da sie diese Aspekte nicht verändern können. Auch dann gilt, entsprechende Kommentare aufgrund ihrer Unveränderbarkeit aus der weiteren Interpretation auszuschließen oder im Gespräch mit den Studierenden (siehe unten: „Mit Studierenden über Lehrevaluationsergebnisse sprechen“) zu diesen Stellung zu nehmen. Dies kann helfen, die Wucht unfairer Kommentare zu reduzieren. Auch im Falle von diskriminierenden oder sexistischen Bemerkungen sollte das Gespräch mit Studierenden gesucht werden, um sich von diesen abzugrenzen. Dabei kann der Anspruch kommuniziert werden, dass von angehenden Akademikerinnen und Akademikern sachliches und konstruktives Feedback erwartet wird. - Ist der Kommentar zutreffend oder wahr?

Beispielkommentar: „Dozent XY schwafelt zu viel und erzählt Dinge, die nichts mit dem Thema zu tun haben. Höchst unprofessionell.“

Negative oder als unfair empfundene Kommentare können aber auch als Anlass genommen werden, sachlich darüber nachzudenken, ob an diesen Hinweisen tatsächlich etwas „dran“ ist. Ein Ergebnis könnte sein, dass es sich um eine Einzelmeinung handelt und/oder betroffene Lehrende dies selbst konträr wahrnehmen. Dann ist es gerechtfertigt, sich von entsprechenden Aussagen zu distanzieren und ihnen keine weitere Beachtung zu schenken.

Sofern entsprechende Kommentare allerdings (über die Zeit) mehrfach vorkommen, sollte tiefergehend reflektiert werden, was die Ursache sein könnte. Vielleicht fehlt dem Vortrag tatsächlich an der einen oder anderen Stelle der rote Faden? Zur Kontrolle der Selbsteinschätzung oder für einen weiteren „objektiven“ Blick, könnte eine vertraute Kollegin oder ein vertrauter Kollege um Besuch der Lehrveranstaltung und Feedback zu dem kritisierten Aspekt gebeten werden.