Prüfungen im Antwort-Wahl-Verfahren

16.05.2023

Aufgaben im Antwort-Wahl-Verfahren, die auch als Multiple-Choice-Fragen bezeichnet werden, kommen an Hochschulen besonders häufig in Vorlesungen mit hohem Prüfungsaufkommen zum Einsatz, weil ihr größter Vorteil gegenüber offenen Aufgaben in einer objektiven und ökonomischen Korrektur liegt (Lindner, Strobel & Köller, 2015).

Auch eine automatisierte Auswertung mittels Scanner (bei sogenannten „Scan-Klausuren“) wird inzwischen von vielen universitären Serviceeinrichtungen angeboten, welche den Arbeitsaufwand und die Beurteilungsfehler auf ein Minimum reduziert. Da die Studierenden zur Beantwortung lediglich Kreuze setzen müssen, können in der Klausurzeit im Gegensatz zu einem offenen Antwortformat mehr Fragen beantwortet werden. Dies ermöglicht eine umfassendere Wissensüberprüfung und erhöht die Messgenauigkeit (Gütekriterium der Reliabilität; ebenda). Ebenso wird vom Prüfungssystem, in das die gescannten Klausuren übertragen werden, automatisch eine Punkte- und Notenübersicht erstellt sowie statistische Analysen, die für eine qualitative Beurteilung und Weiterentwicklung der Fragen sowie der Prüfung insgesamt weiterhelfen (siehe auch Abschnitt „Wie kann ich meine Multiple Choice Klausur evaluieren?“). Voraussetzung für die Durchführung einer Scan-Klausur ist, dass diese mit einer dafür vorgesehenen Prüfungssoftware erstellt wurde. An der TU Darmstadt wird das System EvaExam zur Durchführung von Scan-Klausuren angeboten (Ansprechpartner: E-Learning-Arbeitsgruppe).

Grundsätzlich darf die Entscheidung für ein Prüfungsformat jedoch nicht unabhängig von den Lernzielen einer Veranstaltung getroffen werden (Biggs & Tang, 2011). Dementsprechend gilt es zu überlegen, welche Fähigkeiten und Fertigkeiten der Studierenden überprüft werden sollen und mit welchen Prüfungsformen sich diese erfassen lassen. Für Aufgaben im Antwort-Wahl-Verfahren wird in diesem Zusammenhang häufig eingewandt, dass es für ihre Beantwortung lediglich erforderlich sei die korrekte Antwort wiederzuerkennen. Hingegen müsse bei einem offenen Frageformat Wissen ohne zusätzliche Hinweise abgerufen oder neue kreative Lösungen entwickelt werden.

Tatsächlich eignen sich Aufgaben im Antwort-Wahl-Verfahren besonders gut zur Erfassung von Wissen im Sinne von Blooms kognitiver Lernzieltaxonomie (vgl. Anderson & Krathwohl, 2001). Bei einer sorgfältigen Aufgabenkonstruktion ist es aber durchaus möglich, auch Anwendungs- und Verständnisfragen zu stellen (Lindner et al., 2015). Hierfür eignen sich insbesondere Fallbeispiele, die in Form von Vignetten vorgegeben werden, in denen komplexe Probleme oder Situationen geschildert werden (vgl. Abbildung 3). Auch die Beachtung von Formulierungs- und Gestaltungsregeln für Aufgaben im Antwort-Wahl-Verfahren (sogenannte „Item-Guidelines“, z. B. in Brauns & Schubert, 2008) hilft, hochwertige Aufgaben zu konstruieren, deren Messbereich deutlich über eine reine Wissensabfrage hinausgeht (ebenda).

Bei sorgfältiger Konstruktion von Fragen im Antwort-Wahl-Format können neben Wissen auch höhere kognitive Prozesse (Verständnis und Anwendung, vgl. Anderson & Krathwohl, 2001) abgebildet werden. Hierzu eignen sich insbesondere Fallbeispiele und Vignetten, die weiter unten dargestellt werden. Möchte man darüber hinausgehend noch Prozesse auf höheren Taxonomiestufen der kognitiven Dimension messen, stößt man hinsichtlich der Aufgabenkonstruktion schnell an Grenzen. Insbesondere kreative Leistungen lassen sich mit diesem Aufgabentyp nicht erfassen (vgl. Lindner, Strobel & Köller, 2015). Da die Vorgabe für schrifliche Prüfungen an der TU Darmstadt besagt, dass mindestens 50% der Fragen im offenen Format gestellt werden müssen, empfiehlt es sich, das offene Aufgabenformat zur Überprüfung höherer kognitiver Prozesse (Analysieren, Bewerten oder Generieren, vgl. Anderson & Krathwohl, 2001) zu nutzen und Fragen im Antwort-Wahl-Format zur Überprüfung von Wissen, Verständnis und Anwendung einzusetzen. So werden die unteren Stufen der kognitiven Dimension ökonomisch erfasst und es bleibt mehr Zeit für die Überprüfung anspruchsvollerer Fertigkeiten mit anderen Aufgabenformaten.

Wie Abbildung 1 entnommen werden kann, besteht jede Aufgabe im Antwort-Wahl-Verfahren aus einem Frage- und einem Antwortfeld. Im Fragefeld wird der Fragestamm präsentiert, der auch in eine kurze Erläuterung oder ein Fallbeispiel eingebettet werden kann. Im Antwortfeld sind mehrere Antwortalternativen aufgeführt, von denen ein Teil richtig und ein Teil falsch ist.

Die falschen Antworten, die von der korrekten Antwort möglichst nur bei hinreichendem Prüfungswissen zu unterscheiden sind, werden häufig auch als Distraktoren bezeichnet, da sie die Studierenden von der korrekten Antwortalternative ablenken sollen (engl. to distract). Eine Frage wird beantwortet, indem die richtige(n) Antwort(en) durch ein Kreuz markiert wird/werden (vgl. Brauns & Schubert, 2008; Lindner et al., 2015).

Es gibt viele verschiedene Möglichkeiten, Aufgaben im Antwort-Wahl-Verfahren zu gestalten. Im Folgenden werden einige Frageformate vorgestellt, die sich besonders gut für den Einsatz im Rahmen hochschulischer Prüfungen eignen. Die Darstellung orientiert sich dabei im Wesentlichen an einem Überblicksartikel von Lindner, Strobel und Köller (vgl. Lindner, Strobel und Köller, 2015), in dem diese (und weitere) Antwort-Wahl-Formate diskutiert werden.

Bei der in der ersten Abbildung dargestellten Single-Choice-Aufgabe handelt es sich vermutlich um die bekannteste und an deutschen Hochschulen gängigste Fragevariante. Sie besteht aus einem Fragestamm und einer beliebigen Anzahl von Antwortalternativen, von denen jeweils nur eine korrekt ist. Ein Vorteil dieses Formats liegt darin, dass es Lehrenden und Studierenden gut vertraut ist. Hierdurch fällt die Einhaltung von Konstruktions-, Bearbeitungs- und Auswertungsregeln leichter. Ein Nachteil besteht in der Ratewahrscheinlichkeit, die sich aus der Anzahl der vorgegebenen Antwortalternativen errechnen lässt. Beispielsweise beträgt sie auch bei vier Antworten immer noch 25% und häufig ist es nicht möglich, mehr gute Distraktoren zu generieren (siehe dazu weiter unten).

Eine veränderte Variante des oben beschriebenen Formats stellen Multiple-Response-Aufgaben dar. Dieser Fragentyp ist vom Aufbau mit Single-Choice-Aufgaben identisch. Allerdings sind hier beliebig viele (bis hin zu alle) Antwortalternativen zulässig. Dies hat den Vorteil, dass durch die Option zur mehrfachen Auswahl die Ratewahrscheinlichkeit deutlich verringert wird. Die grundsätzliche Problematik, geeignete Distraktoren zu finden, bleibt für diesen Aufgabentyp jedoch bestehen. Allerdings wird hierbei die Anzahl der Antwortalternativen auch durch mehrere korrekte Antworten erhöht, die üblicherweise leichter zu erstellen sind als Distraktoren.

Eine weitere Variante dieser Grundform stellen Alternate-Choice-Aufgaben dar, welche auch unter der Bezeichnung Ja/Nein- beziehungsweise Wahr/Falsch-Fragen bekannt sind. Bei diesem Aufgabentyp gibt es von vorne herein nur zwei Antwortalternativen – eine korrekte und eine falsche. Dies ergibt vor dem Hintergrund des Distraktorproblems häufig mehr Sinn, allerdings ist die Ratewahrscheinlichkeit mit 50% sehr hoch. Daher empfiehlt es sich, für Fragen mit nur zwei Antwortalternativen mehrere Aussagen zu generieren und diese in eine Multiple-True-False-Aufgabe (auch „K-Prim-Aufgabe“ genannt) zu überführen, wie sie in Abbildung 2 dargestellt ist. Hier stehen mehrere Aussagen untereinander, die jede für sich bewertet werden muss. Ein Vorteil dieses Formats liegt darin, dass die Lesezeit gegenüber den anderen Aufgabenformaten deutlich verkürzt wird. So können mehr diagnostische Informationen pro Zeiteinheit gewonnen werden, was die Reliabilität, also die Zuverlässigkeit der Messung, erhöht. Bei der Kreditierung der Aufgabe wird nur dann ein Punkt vergeben, wenn alle Aussagen richtig bewertet wurden. Hierdurch wird die Ratewahrscheinlichkeit gegenüber Alternate-Choice-Aufgaben deutlich gesenkt.

Eine Aufgabenart, die zur Leistungsüberprüfung an Hochschulen seltener eingesetzt wird, ist die in Abbildung 3 dargestellte Matching-Aufgabe. Sie besteht aus einer beliebigen Anzahl von Fragestämmen und Antwortalternativen, die einander korrekt zugeordnet werden sollen, z. B. Jahreszahlen und geschichtliche Ereignisse (Lindner et al., 2015). Der Vorteil dieses Aufgabentyps liegt darin, dass er weniger Platz benötigt als andere Formate und auch die Lesezeit gering gehalten wird, wodurch insgesamt mehr Aufgaben bearbeitet werden können. Durch die Vorgabe einer ungleichen Anzahl von Fragestämmen und Alternativen kann zudem die Ratewahrscheinlichkeit verringert werden, da die Anwendung des Ausschlussverfahrens nicht mehr möglich ist. Diese Aufgabenform eignet sich insbesondere für E-Assessments, wenn die Antworten als interaktive Elemente programmiert wurden und mit der Maus angefasst und verschoben werden können (Drag & Drop).

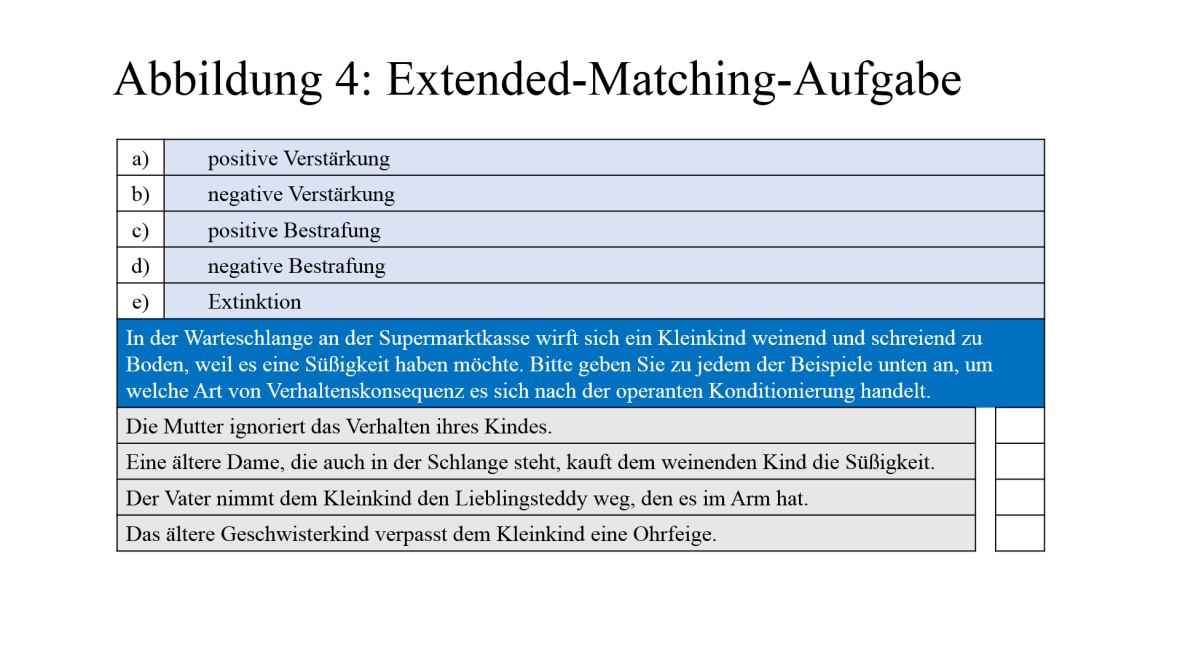

Für Paper-Pencil-Klausuren gestaltet sich die Auswertung von Matching-Aufgaben schwierig, insbesondere wenn die Studierenden ihre Antworten korrigieren. Daher sollte man hier besser auf Extended-Matching-Aufgaben zurückgreifen, die eine formale Abwandlung des oben beschriebenen Fragetyps darstellen. Wie Abbildung 4 zu entnehmen ist, steht bei dieser Aufgabenvariante eine durchnummerierte Liste von Antwortalternativen zur Verfügung. Das Fragefeld beinhaltet ein Lead-In-Statement, welches den notwendigen Kontext für die Fragenbeantwortung herstellt. Den sich darunter befindlichen Aussagen sollen nun die oben aufgeführten Antwortalternativen zugeordnet werden. Im vorliegenden Beispiel sind mehr Antworten vorgegeben als es Aussagen gibt, um die Ratewahrscheinlichkeit zu verringern. Allerdings wird für diesen Aufgabentyp empfohlen, besser mehr Aufgaben vorzugeben anstatt lange Itemlisten einzusetzen (Lindner et al., 2015). Er ist besonders gut für den Einsatz von Fallvignetten geeignet, die es erlauben, auch komplexe Kompetenzen wie das Verstehen oder Anwenden zu erfassen. Durch die relativ schnelle Bearbeitungszeit stehen mehr Einzelinformationen über das Können der Studierenden zur Verfügung als bei anderen Aufgabenformaten, was wiederum die Reliabilität der Messung erhöht.

Grundsätzlich können alle bisher genannten Fragetypen sowohl in Paper-Pencil-Klausuren als auch in E-Prüfungen eingesetzt werden. Ein weiterer Fragentyp, Long-Menu-Questions, kommt ausschließlich für computerbasierte Prüfungen in Betracht. Hierbei steht unter dem Itemstamm in einem Drop-Down-Menü eine sehr lange Antwortliste zur Verfügung, wobei jedoch nur eine der Antworten korrekt ist. Aufgrund der unüberschaubaren Antwortzahl haben nur Personen, welche die Antwort auch frei generieren könnten, die Möglichkeit, den richtigen Begriff gezielt aus der Liste herauszusuchen und die Frage zu beantworten. So wird die Ratewahrscheinlichkeit auf ein Minimum reduziert.

Ganz egal, für welches Frageformat man sich entscheidet: Die Frageformate sollten den Studierenden möglichst bereits vertraut sein oder sie sollten in der Veranstaltung damit vertraut gemacht werden. Bei der Gestaltung der Klausur sollte des Weiteren darauf geachtet werden, dass den Studierenden eindeutige Instruktionen zur Fragenbeantwortung vorgegeben werden. Hierzu gehört auch, dass sie aus Gründen der Testfairness über die à priori Ratewahrscheinlichkeit informiert werden (Brauns & Schubert, 2008).

Die Instruktion erfordert eine besondere Sorgfalt, wenn in einer Klausur eine Mischung aus mehreren Fragetypen vorgegeben wird. Bei einer Kombination von Single-Choice- und Multiple-Response-Aufgaben ist dies recht einfach möglich, wenn auf dem Deckblatt darauf hingewiesen wird, dass bei allen Fragen immer mindestens eine bis zu maximal alle der vorgegebenen Antwortalternativen anzukreuzen sind. Werden mehrere Formate alternierend dargeboten, empfiehlt es sich, die Bearbeitungsinstruktionen vor jeder Aufgabe mitzuteilen, auch wenn dies den Leseaufwand und damit die Bearbeitungszeit beträchtlich erhöht. Daher sollte der Fragentyp möglichst vor der Klausurkonstruktion festgelegt und nicht zu viele unterschiedliche Typen auf einmal zum Einsatz gebracht werden, wenn die Studierenden im Umgang mit diesen nicht geübt sind. Je nach Hochschule gibt es zudem oftmals auch obligatorische Richtlinien, die durch die Prüfungsordnung vorgegeben sind. An der TU Darmstadt dürfen Aufgaben im Antwort-Wahl-Verfahren den Anteil von 50% der Gesamtpunktzahl nicht übersteigen. Des Weiteren muss bei jeder Aufgabe angegeben werden, wie viele Antworten richtig sind und wie viele Punkte es auf die Aufgabe gibt.

Sacher, W. (2014). Leistungen entwickeln, überprüfen und beurteilen. Bewährte und neue Wege für die Primar- und Sekundarstufe (6., überarb. und erw. Aufl). Bad Heilbrunn: Klinkhardt.

King, A. (1992). Facilitating Elaborative Learning Through Guided Student-Generated Questioning. Educational Psychologist, 27 (1), 111–126.

Ingenkamp, K. & Lissmann, U. (2008). Lehrbuch der pädagogischen Diagnostik (6. Aufl.). Weinheim: Beltz.

Franze, A. & Zastrau, B. W. (2016). Mehr als ein Kuchendiagramm – Möglichkeiten der Prüfungsauswertung. HDS.Journal, 1/2016, 34–38. Zugriff am 18.08.2016. Verfügbar unter http://ul.qucosa.de/fileadmin/data/qucosa/documents/20260/hds_jounal_I_2016-2.pdf

Biggs, J. B. & Tang, C. S.-k. (2011). Teaching for quality learning at university. What the student does (4th ed.). Maidenhead: McGraw-Hill.

Lindner, M. A., Strobel, B. & Köller, O. (2015). Multiple-Choice-Prüfungen an Hochschulen? Zeitschrift für Pädagogische Psychologie, 29 (3-4), 133–149.

Brauns, K. & Schubert, S. (2008). Qualitätssicherung von Multiple-Choice-Prüfungen. In S. Dany, B. Szczyrba & J. Wildt (Hrsg.), Prüfungen auf die Agenda! Hochschuldidaktische Perspektiven auf Reformen im Prüfungswesen (1. Aufl., S. 93–102). Bielefeld: Bertelsmann.

Anderson, L. W. & Krathwohl, D. R. (2001). A taxonomy for learning, teaching, and assessing. A revision of Bloom's taxonomy of educational objectives. New York: Longman.